2025年1月に登場したDeepSeek-R1が話題になっている。MITライセンスの下で公開されており、さっそくサイバーエージェントが日本語データで追加学習を行ったLLM(cyberagent/DeepSeek-R1-Distill-Qwen-32B-Japanese)を公開した。

【モデル公開のお知らせ】

— サイバーエージェント 広報&IR (@CyberAgent_PR) January 27, 2025

DeepSeek-R1-Distill-Qwen-14B/32Bをベースに日本語データで追加学習を行ったLLMを公開いたしました。今後もモデル公開や産学連携を通じて国内の自然言語処理技術の発展に貢献してまいります。 https://t.co/Oi0l2ITzhh

これが、どうやらM4 ProのMacBookProだと動きそうだ、との噂で、実際にやってみたら、、

予想以上に簡単に動いた。モデルのダウンロード速度にもよるけれど、以下の手順で進めたら5分で動くので試して欲しい、ということで手順をまとめると、

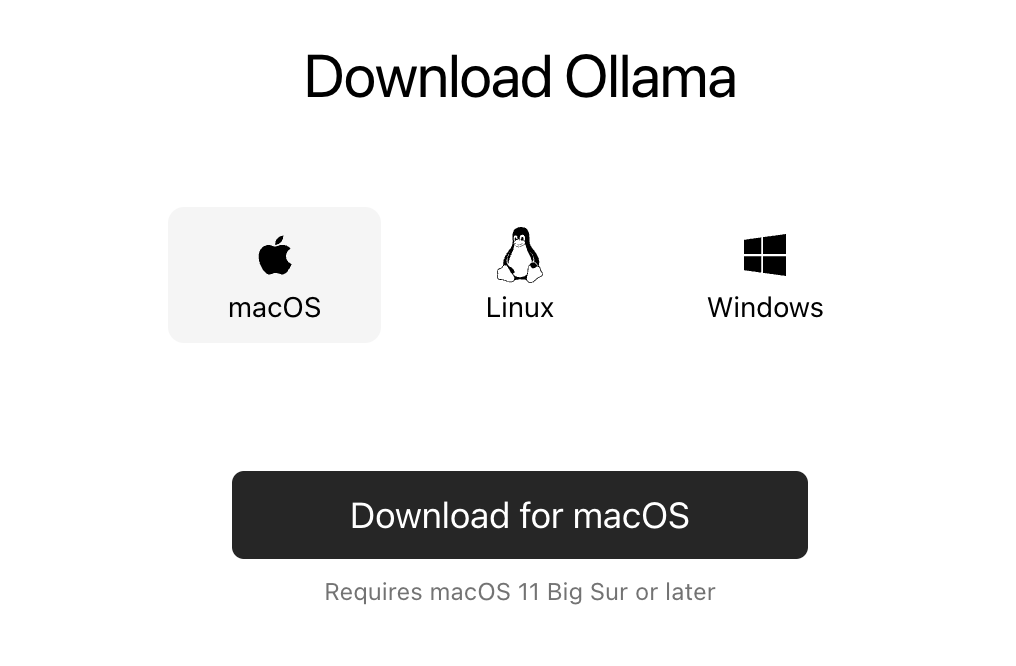

Ollamaのインストール

下のリンクを開き、「Download ↓ 」ボタンをクリックして進み、

開いた画面の「Download for macOS」ボタンをクリックし、

Ollama-darwin.zip ファイルがダウンロードできる。これを解凍し「ollama」のアプリケーションを「アプリケーションフォルダ」に移動し、起動する。これでインストール完了。

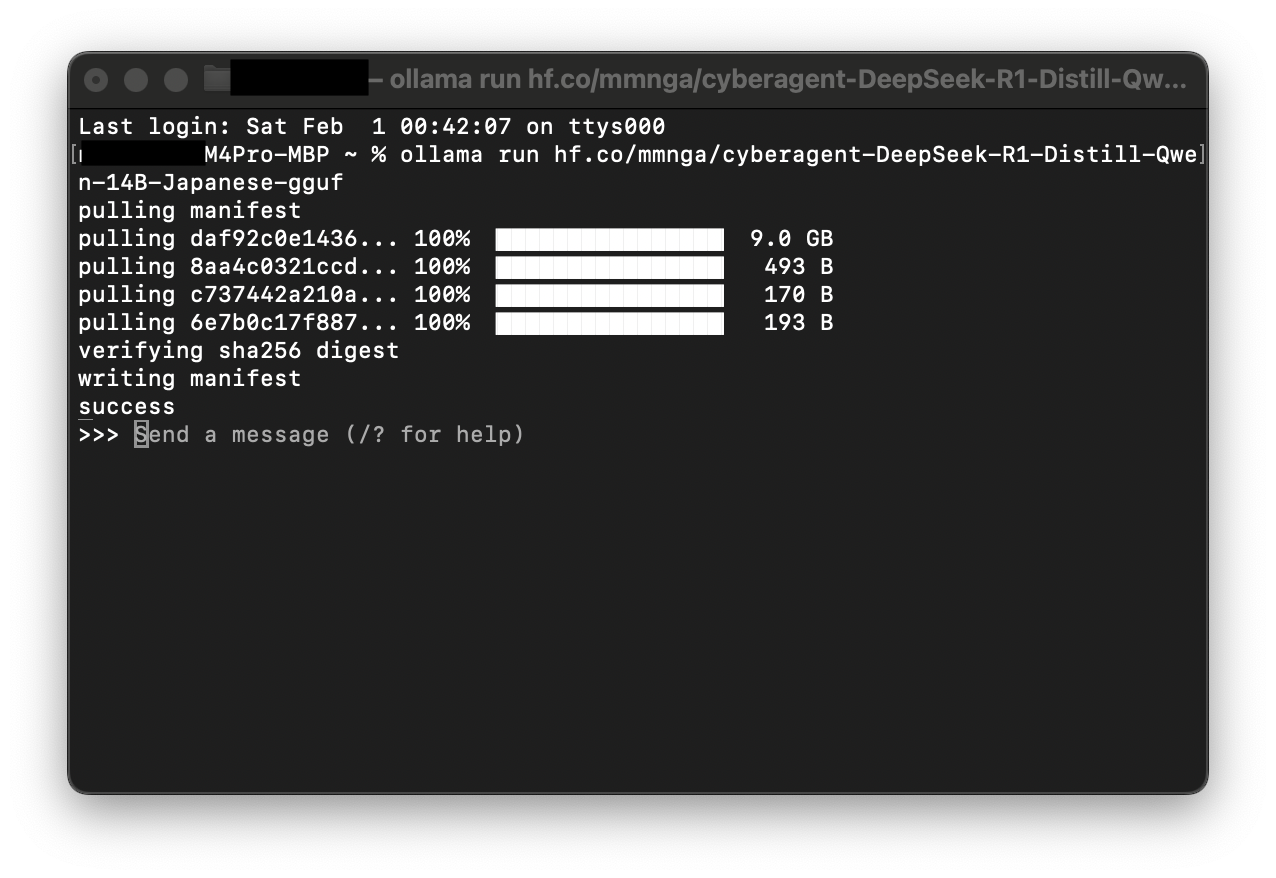

サイバーエージェントのLLMモデルを導入する

cyberagent/DeepSeek-R1-Distill-Qwen-32B-Japanese (Hugging Face)をollama に導入するには、コマンドプロンプトのホームフォルダで、下のコマンドをコピペで実行するだけ。

ollama run hf.co/mmnga/cyberagent-DeepSeek-R1-Distill-Qwen-14B-Japanese-ggufこれで導入完了、実行できる状態になる。

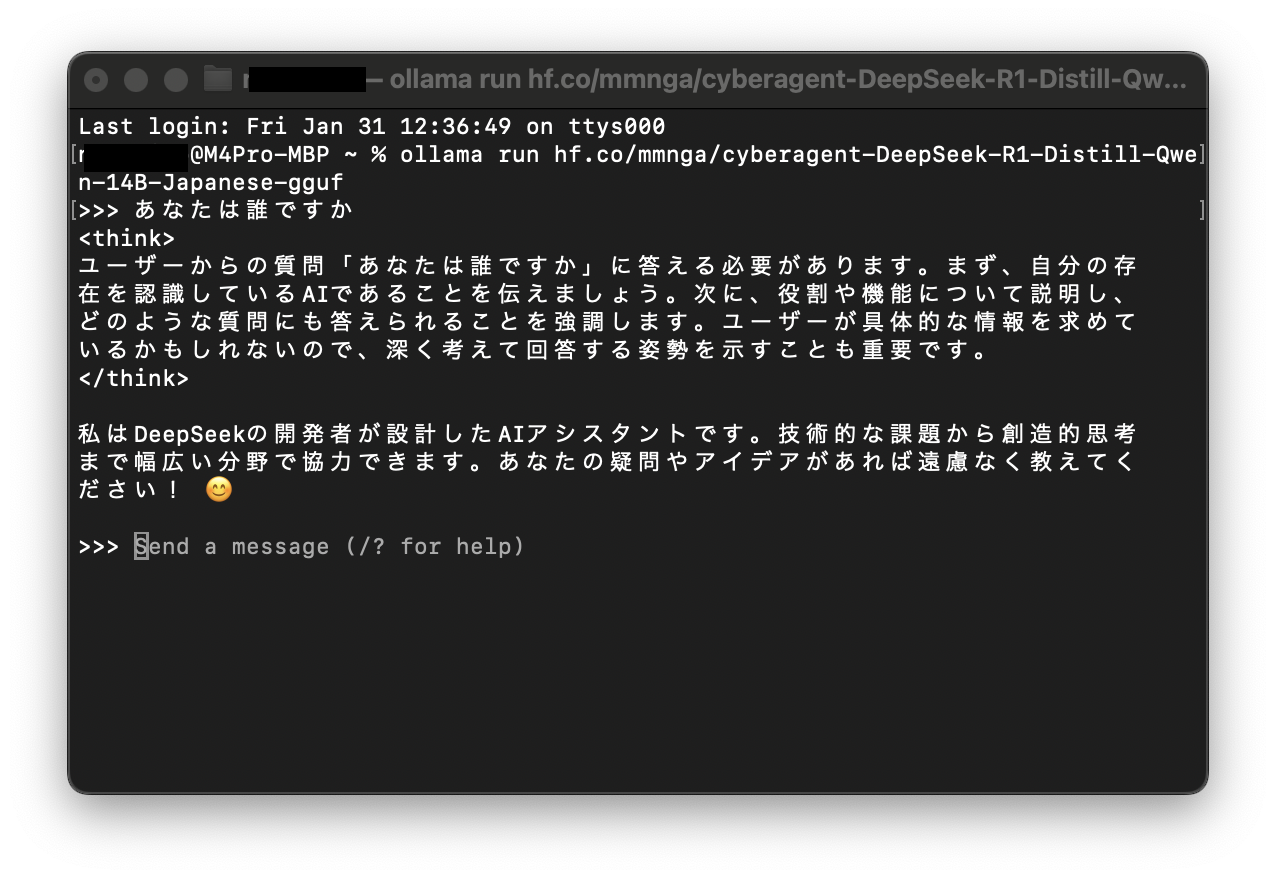

ここの「>> Send a message」にプロンプトを日本語で入力してやりとりできる。

14Bモデルを 24GBメモリで実行すると、ちょっと待つ時間があるけど、なんとか実用できる感じで動作する。(Chromeなどメモリを必要とするアプリと併用はさせるのが大吉な感じ)

終了させるには

/byeと入力すると、コマンドプロンプトに戻る。起動するには、上の長いコマンドをもう一度入力するとOKで、2回目以降はダウンロードなしで起動する。

ollama に導入済のモデルを確認するのは、

ollama listollamaに導入したけど、使わなくなったモデルを削除するには、

ollama rm モデル名にて削除できる。

cyberagent/DeepSeek-R1-Distill-Qwen-32B-Japaneseを使うには深津プロンプトが良さそう

使ってみた感想は、GPT-3.5 Turbo ぐらいな感触で、深津プロンプトを使うと、良い感じに推論してくれる感じだった。

#命令書:

あなたは、です。

以下の制約条件と入力文をもとに、最高の結果を出力してください。

#制約条件:

#入力文:

#出力文:学習より推論が鍵になる

こちらの記事の中で鍵だと感じる部分を引用すると、

扱えるトークン数が多くなればなるほど、学習する必然性は無くなっていく。今のLLMは「インコンテキストラーニング」というものが主流だ。実際に学習させるのではなく、プロンプトに答えを含ませてしまうのだ。そうすれば確実に欲しい答えが得られる。

先ほど述べたように、「学習」が必要な時代は終わりを迎えつつある。

文章生成ならインコンテキストラーニング、画像や動画生成ならリファレンス画像やリファレンス動画をもとによりクリエイターの意図を的確に伝える時代が到来している。これからは学習ではなく推論が遥かに重要になる。

同感で、インコンテキストラーニングで推論AI(生成AI)を使って答えを尋ねず、作業を任せる使い方を行なっている。それが、ローカルマシンで動いた一歩と感じる。

正直、MacBookProのメモリを詰めるだけ積んで買えばよかった?と感じる点もあるが、逆に24GBモデルでも動く体験ができたので、貴重な体験をできたと感じる。